Et si Internet était en train d’oublier ce qu’il a appris ? On parle de plus en plus du Model Collapse, ce moment où les IA s’effondrent… après s’être nourries de leurs propres contenus.

Sur internet et autres réseaux sociaux, on entend de plus en plus parler de "Model Collapse", qu'on peut traduire par "effondrement des modèles d'IA", un phénomène où l'efficacité d'un modèle se réduit lorsque des données générées par IA sont utilisées pour l'entraînement.

Ce sujet est déjà documenté depuis plusieurs années par les spécialistes de cette industrie, mais c'est seulement depuis cette année que ce sujet fait parler, comme si une révélation s'était produite.

L'édition de cette semaine sera justement l'occasion de faire le point sur l'effondrement des modèles : en quoi ça consiste, pourquoi on en parle, et quelles sont les solutions si elles existent.

Le Model Collapse, c'est quoi ?

Prenons d’abord le temps d’enfoncer les portes ouvertes : les modèles d’IA générative tels qu’on les connaît aujourd’hui comme GPT-5, Claude ou Gemini sont conçus pour créer du contenu nouveau à partir des données avec lesquelles ces modèles ont été entraînés.

Ce contenu généré par l’IA peut être utilisé en tant que données d’entraînement pour d’autres modèles d’IA, et c’est précisément là que les problèmes commencent.

En effet, la génération de contenu réalisée par un modèle d’IA n’est jamais vraiment parfaite. Tous les modèles d’IA sans exception introduisent leurs propres biais ainsi que des erreurs statistiques qui dégradent la qualité du contenu.

Le phénomène est comparable à la traduction d’une autre langue. Lorsqu’on traduit un texte d’une langue à une autre, certaines expressions sont difficilement traduisibles et nécessitent d’autres mots, ce qui implique une perte de subtilité et/ou la possibilité d’une erreur dans ce qu’on veut vraiment dire.

Maintenant, que se passe-t-il si on traduit un texte français en anglais, puis en mandarin, puis en espagnol, puis à nouveau en français ? Il y a de fortes chances que le texte final soit incompréhensible, car les pertes de signification et les risques d’erreur se multiplient à chaque traduction.

Il se passe exactement la même chose avec l’IA lorsqu’on entraîne des modèles avec des données également artificielles. À mesure qu’on utilise de plus en plus de contenu synthétique, les modèles entraînés sur ces types de contenu perdent en performance.

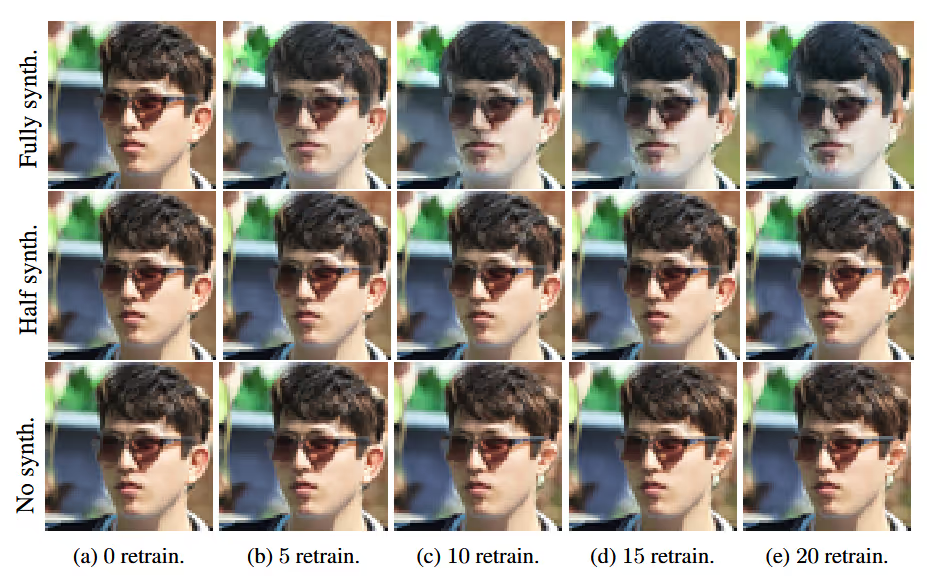

On peut constater cette perte de performance sur l’image ci-dessus : lorsqu’un modèle d’IA a été entraîné sans aucun contenu synthétique, ses performances sont constantes. En revanche, si un modèle est entraîné uniquement sur du contenu créé par l'IA, les entraînements successifs font drastiquement baisser l’efficacité du modèle.

Les causes de l'effondrement

Si on s’intéresse plus en détail aux mécanismes qui provoquent l’effondrement des modèles, on parvient à identifier trois raisons principales.

La première est l’erreur d’approximation fonctionnelle. Cela survient quand le modèle d'IA ne parvient pas à capturer correctement la relation entre les variables d'entrée et de sortie.

C’est comme si une IA essayait de dessiner des montagnes russes avec une règle. Soit le modèle a choisi le mauvais outil parmi ceux qu’il peut manipuler, soit le modèle ne sait que dessiner avec une règle. Dans les deux cas, c’est une tâche impossible à réaliser correctement.

La deuxième raison est l’erreur d'échantillonnage, qui se produit quand les données utilisées pour entraîner le modèle ne sont pas représentatives de la population réelle. Si les données d’entraînement ne sont pas diversifiées, le modèle sera dépassé face à de nouvelles situations.

Une personne qui apprend à conduire uniquement sur des routes de campagne aura très peu de chances de conduire correctement dans une grande ville aux heures de pointe.

La dernière raison expliquant l’effondrement des modèles est l’erreur d’apprentissage. Dans ce cas, deux problèmes opposés peuvent survenir :

- Le surapprentissage, où le modèle s'adapte tellement aux détails des données d'entraînement qu'il perd sa capacité à généraliser, un peu comme du bachotage.

- Le sous-apprentissage, où un modèle observe les données en diagonale sans les assimiler.

Par ailleurs, ces trois types d'erreurs s'alimentent mutuellement. Un modèle trop simple (approximation fonctionnelle) entraîné sur des données biaisées (erreur d’échantillonnage) aura tendance à mal apprendre (erreur d’apprentissage), ce qui accélère son effondrement.

Faut-il s'en inquiéter ?

Chez les professionnels de l’IA, le sujet de l’effondrement des modèles existe déjà depuis plusieurs années :

- La première recherche ayant pour but de formaliser l’effondrement des modèles remonte à 2021 (Shumailov), où l’on observait que les modèles entraînés sur leurs propres sorties dégradaient au bout de 4-5 itérations.

- Une autre étude publiée dans la revue Nature en 2024 qui portait sur plus d’un milliard de données montrait une perte irréversible de diversité linguistique dès la 2e génération.

- Enfin, des travaux provenant du MIT montrent que les jeux de données 100% créés par l’IA s'effondrent en 3 cycles d’entraînement

Il s’agit donc d’un sujet relativement connu et documenté dans le secteur. Pourtant, le sujet de l’effondrement des modèles n’a jamais été aussi populaire sur internet qu’aujourd’hui, la faute principalement à l’utilisation croissante de l’IA dans notre quotidien.

Avec la prolifération du contenu généré par IA sur le net, il devient de plus en plus difficile de distinguer les données "authentiques" (créées par des humains) des données synthétiques, à un tel point que des données synthétiques pourraient à terme se retrouver dans les données d’entraînement des modèles d’IA.

Si les futurs modèles sont entraînés sur un web majoritairement généré par IA, ils risquent tous de subir cet effondrement progressif.

Les opinions divergent

C’est un fait bien établi aujourd’hui, le pourcentage de contenu généré par IA par rapport à la totalité d’internet est en hausse constante depuis plusieurs années. Selon l'organisation à but non lucratif Common Crawl, le ratio de contenu généré par IA représente 30% de la totalité du web en 2025.

Mais quand il s’agit de savoir comment cela va impacter les performances des modèles d’IA, on peut voir tout et son contraire en termes d’opinions.

Du côté des communautés Open Source comme Hugging Face, il y a une vraie inquiétude que les datasets publics soient dégradés par du contenu synthétique et que cette perte de performance soit inévitable.

Dans le camp opposé, nous avons des chercheurs comme Yann Le Cun ou Andrej Karpathy qui pensent que l’effondrement des modèles est surtout dû à un mauvais tri dans les données d’entraînement, et non à une fatalité.

Se protéger contre le Model Collapse

Peu importe ce qui se passe, il existe plusieurs moyens à différentes échelles pour éviter que ce phénomène se produise.

On a déjà mentionné plus haut que l’effondrement des modèles est dû à un mauvais tri des données. Donc il est possible de s’en protéger avec un meilleur tri, qui peut se faire de plusieurs façons :

- Curation aggressive (filtrage IA)

- Données "fraîches" (livres non numérisés, données scientifiques…)

- Utilisation de benchmarks "anti-IA"

Voilà ce qu’on peut faire au niveau des datasets, mais on peut aussi agir en dehors de ces derniers.

Méthodes d'entraînement

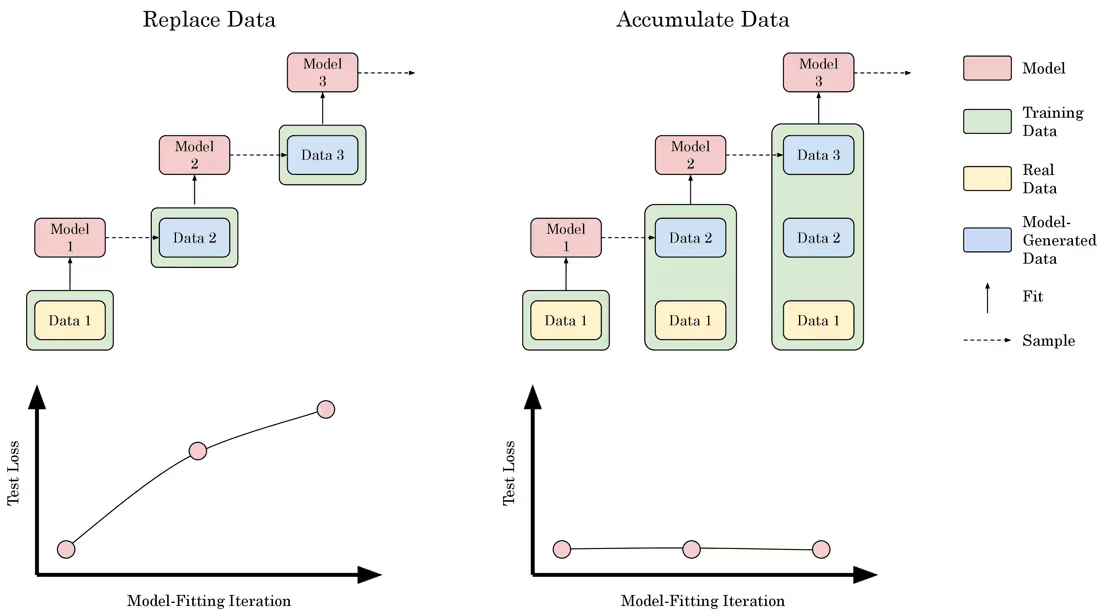

La façon dont on entraîne un modèle d’IA a aussi un grand impact sur l’influence de l’effondrement du modèle, comme indiqué ci-dessous :

La mauvaise méthode est d’utiliser des données totalement différentes à chaque cycle d’entraînement. On peut voir sur le graphique de gauche que les pertes de performances augmentent à chaque cycle en utilisant cette méthode.

Une autre approche est qu’à chaque cycle d’entraînement, on réutilise toutes les données employées précédemment + les données spécifiques à ce cycle. Ainsi, les performances restent constantes.

Changer de modèle économique

Si beaucoup d’utilisateurs craignent qu’internet soit envahi de contenu artificiel, c’est surtout parce que certains modèles économiques encouragent à le faire.

Les modèles économiques comme les revenus publicitaires ou le streaming privilégient beaucoup la quantité à la qualité. Par conséquent, on utilise l’IA systématiquement car l’incitation économique est beaucoup plus forte que si on créait du contenu manuellement.

En réponse à ces problèmes, on explore des modèles alternatifs comme celui du “Pay-Per-Crawl” créé par Cloudflare où chaque bot (robot d’indexation, récolte de données…) doit payer un montant défini par le créateur pour accéder au site web. S’il paie, il peut accéder au site et à ses données. Dans le cas contraire, son accès est bloqué.

Il existe même des initiatives comme le protocole de paiement x402 qui cherche à intégrer les paiements des agents IA sur la blockchain avec le stablecoin USDC.

Dès lors qu’il y a plus d’intérêt économique à privilégier la qualité à la quantité, le contenu généré par IA est moins nocif s’il est utilisé dans les données d’entraînement. Et pour y parvenir, il est nécessaire d’adopter des modèles économiques allant dans ce sens.

En guise de conclusion

Pour conclure sur ce sujet, l’effondrement des modèles est un risque réel, mais il est beaucoup plus considéré comme un problème d'ingénierie et beaucoup moins comme une catastrophe inévitable.

Un bon indice pour savoir si l’effondrement des modèles est un problème ou non est de surveiller les datasets Open Source tels que “The Pile” ou “RedPajama” dont la curation est réalisée tous les mois. Tant que leurs objectifs de propreté sont atteints, il ne s’agit pas d’un problème…Jusqu’à preuve du contraire.

Voilà qui termine ce sujet, en espérant que cela vous aide à comprendre les tenants et les aboutissants de ce phénomène. Et si vous souhaitez approfondir vos connaissances liées à l’IA, nous vous proposons de découvrir les formations gratuites IA.

{{cta-moyen-cia}}

Webinar gratuit

Nos experts répondent à vos questions sur l'intelligence artificielle !

S'inscrire au Webinaire

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Finance Décentralisée

Accédez gratuitement à vos premières heures de formation Finance décentralisée

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

Découvrez toutes nos formations en intelligence artificielle

Découvrez toutes nos formations Crypto

.avif)