Au cours des cinq dernières années, l’industrie de l’Intelligence Artificielle avait pris le parti de privilégier le “Scaling”, une idée selon laquelle les performances d’une IA étaient corrélés à son poids ou la puissance de calcul utilisée.

Mais depuis l’année dernière, le Scaling est de plus en plus délaissé au profit de l’apprentissage par renforcement, qui est bien plus adapté aux enjeux actuels de l’IA.

Les limites du Scaling

Si l’apprentissage par renforcement connaît un regain de popularité récemment, c’est principalement car certaines approches viennent d’atteindre leurs limites, notamment celle du “Scaling”.

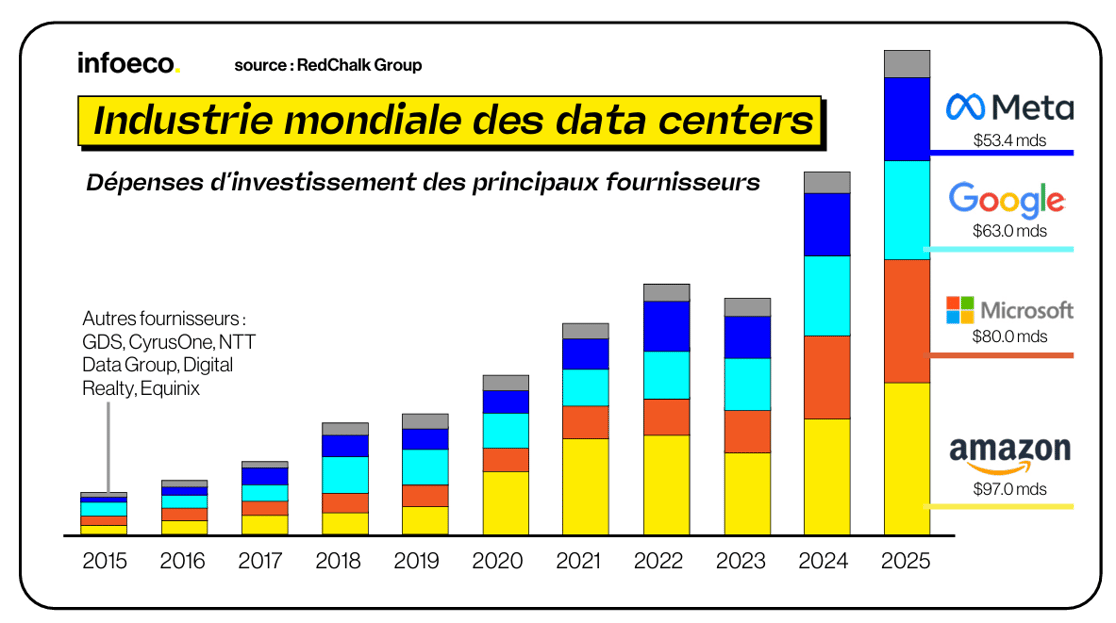

Entre 2020 et 2025 avait lieu l’âge du Scaling, où l’on pensait que plus d'infrastructures (notamment plus de puissance de calcul) permettait d’avoir des modèles d’IA plus performants.

Si on combine une puissance de calcul définie, avec des jeux de données définis dans un réseau de neurones d’une taille spécifique, on a des résultats. Et on sait qu’ils seront encore meilleurs si on en met davantage.

Pour les entreprises, cela donne l’argument suivant : “Avec plus d’infrastructure, nos modèles d’IA sont plus performants”. C’est un argument qui évoque peu de risques et une augmentation prévisible des performances.

Ainsi, il devient plus facile pour les entreprises de justifier des levées de fonds ou la mise en place d’infrastructures toujours plus grandes.

Mais en adoptant cette approche, les entreprises d’IA se retrouvent confrontées à des problèmes multiples.

Avec le scaling, le but n’est plus d’avoir le modèle le plus optimal, mais d’avoir la plus grande infrastructure possible, ce qui fait que les grands gagnants sont les entreprises capables de mobiliser le plus de moyens, au détriment des modèles les plus aboutis technologiquement.

En parallèle, nous sommes dans un environnement où les données d’entraînement sont finies et où la puissance de calcul est également finie, par conséquent la performance d’un modèle d’IA aura toujours un plafond de verre.

Enfin, le dernier problème qui met à mal la crédibilité du Scaling est que de plus en plus d’études scientifiques démontrent que les performances réelles des modèles d’IA ne sont pas forcément corrélées à leur infrastructure. Pire encore, cette performance peut aussi diminuer en fonction de la puissance de calcul mobilisée.

Finalement, la performance d’un modèle d’IA n’a jamais été un problème de ressource (contrairement à ce que le Scaling suggère), et a toujours été un problème d'ingénierie, avec entre autres la correction des biais. Il fallait donc une autre approche, et c'est de cette façon que l'apprentissage par renforcement est revenu à l'ordre du jour.

Le retour de l'apprentissage par renforcement

Contourner le problème de l'étiquetage humain

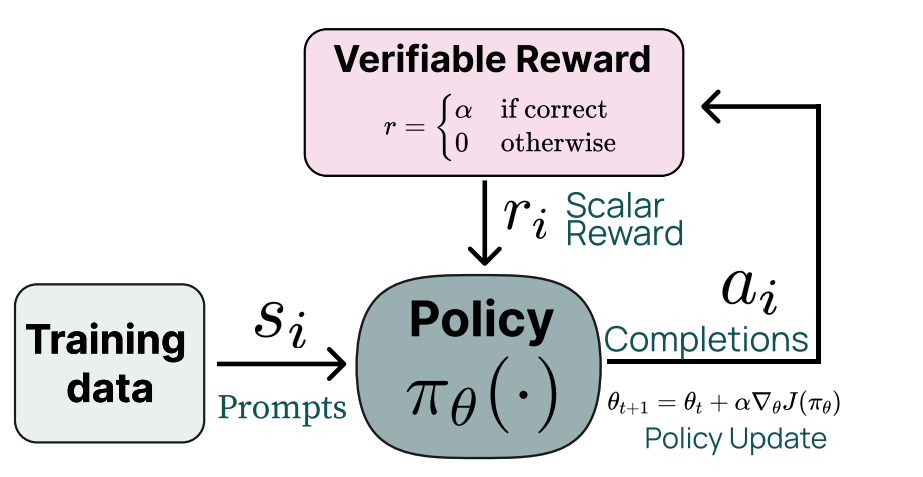

Le modèle d’IA DeepSeek-R1 sorti en janvier 2025 a été l’initiateur de ce retour, notamment en proposant une stratégie d’apprentissage plus large appelée “Reinforcement Learning from Verifiable Rewards (RLVR)”, qui consiste à remplacer le vérificateur humain par un vérificateur algorithmique.

Le système fonctionne comme suit :

- Le modèle génère une solution

- Un vérificateur (qui est un programme ou une fonction) évalue si la réponse est correcte

- L'algorithme d’apprentissage par renforcement met à jour le poids du modèle en fonction de la réponse qui peut être vraie ou fausse

Ce paradigme constitue une véritable alternative à l’apprentissage par renforcement via feedbacks humains (RLHF), car le RLVR peut traiter des millions d'instances générées synthétiquement, permettant au modèle d'explorer et d'optimiser ses stratégies de raisonnement sur des volumes de données jamais accessibles avant.

L’étiquetage humain (RLHF) constitue un goulot d’étranglement pour l’apprentissage par renforcement, et le RLVR a permis de contourner ce problème.

Le Test-Time Compute

Le Test-Time Compute est une approche bien différente qui ajuste les paramètres d'un modèle d'IA directement pendant l'inférence.

C’est un peu comme si le modèle d’IA avait une mini-séance d’entraînement qui lui laissait le temps de réfléchir avant de répondre, ce qui est très différent des modèles d’IA actuels qui, si on poursuit la comparaison, n’ont qu’une grande séance d’entraînement qui sert de base pour toutes leurs réponses.

Cette approche affiche déjà des performances très intéressantes par rapport aux méthodes classiques. En effet, le modèle s1-32B (un modèle optimisé de Qwen2.5-32B Instruct) est parvenu à surpasser les performances du modèle o1 OpenAI avec très peu d'entraînement.

Raisonner uniquement quand c'est nécessaire

Dans l’industrie de l’IA, la tendance actuelle pousse les modèles à "réfléchir" via des chaînes de raisonnement. Le problème est que le prix dépensé en puissance de calcul explose pour chaque requête.

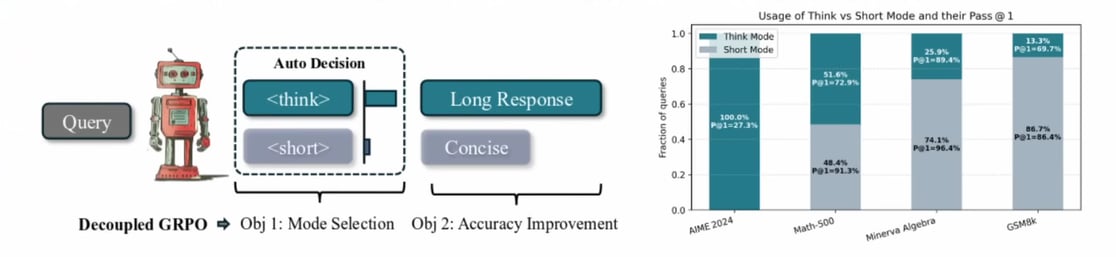

Un article nommé “Thinkless” adopte une position différente. Cet article considère le raisonnement comme une dépense, et les modèles d’IA doivent apprendre à savoir quand raisonner pour dépenser le moins possible.

Concrètement, le modèle d’IA dispose de deux modes de fonctionnement distincts

- Pour les tâches simples, il fournit une réponse courte et immédiate.

- Pour les problèmes complexes, il active un processus de réflexion détaillé.

L'innovation majeure est que c'est le modèle lui-même qui choisit le mode à adopter pour chaque question, et ce choix est appris via l’apprentissage par renforcement.

Cette méthode permet d'éviter le gaspillage de puissance de calcul sur des requêtes triviales. Selon les résultats publiés dans l’article, le modèle génère 50 à 90% de tokens en moins, et sans perte de performance sur les tâches.

Est-ce vraiment une solution miracle ?

Le fait que l’apprentissage par renforcement revienne sur le devant de la scène n’est pas un hasard. L’industrie de l’IA dans son ensemble réalise que le Scaling n’est plus une approche propice à l’innovation, et on se concentre désormais sur l’optimisation de la structure interne du modèle, où l’apprentissage par renforcement est particulièrement adapté.

Pour autant, cette méthode fait encore l’objet de beaucoup de débats chez les chercheurs.

Les "modèles de récompense" qui sont utilisés pour noter et entraîner les IA (notamment le RLVR de DeepSeek-R1) peinent à évaluer correctement les réponses à des questions ouvertes ou ambigües.

Ce système excelle dans les domaines purement logiques comme les maths ou le code, mais dès qu’il s’agit de domaines plus complexes comme la nuance, la créativité ou la justice, les modèles de récompenses favorisent les réponses lisses.

Ainsi, en cherchant à maximiser ces récompenses (le cœur du RL), les modèles convergent vers des réponses identiques, réduisant la diversité et favorisant la "conformité au moule" plutôt qu'une véritable preuve d'intelligence.

Malgré tout, nous sommes en train d’arriver dans un nouveau paradigme où les modèles n’absorbent plus passivement des données, mais explorent activement et optimisent leurs stratégies de raisonnement.

Les innovations dans l’intelligence artificielle sont toujours en cours, c’est juste que les recherches sont en train de changer de direction. Et si vous souhaitez approfondir vos connaissances liées à l’IA, nous vous proposons de découvrir tout ceci avec la formation gratuite IA !

Webinar gratuit

Nos experts répondent à vos questions sur l'intelligence artificielle !

S'inscrire au Webinaire

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Finance Décentralisée

Accédez gratuitement à vos premières heures de formation Finance décentralisée

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

.avif)