Les modèles Open Weight rivalisent avec les IA propriétaires, tout en étant plus ouverts, accessibles et économiques.

A l’heure actuelle, les modèles d’IA en source fermée (les modèles où le code source, les données d’entraînement et les poids ne sont pas accessibles) sont les plus utilisés au détriment des modèles plus transparents. La raison principale à cela est que les modèles en source fermée sont la plupart du temps plus performants.

Mais depuis l’année dernière, il y a une véritable effervescence du côté des modèles Open Weight (où les poids sont accessibles). Non seulement ces modèles parviennent à réduire l’écart de performance, mais en plus l’accès au paramètres permet de faire tourner des modèles sur différentes machines.

Un rapprochement des performances

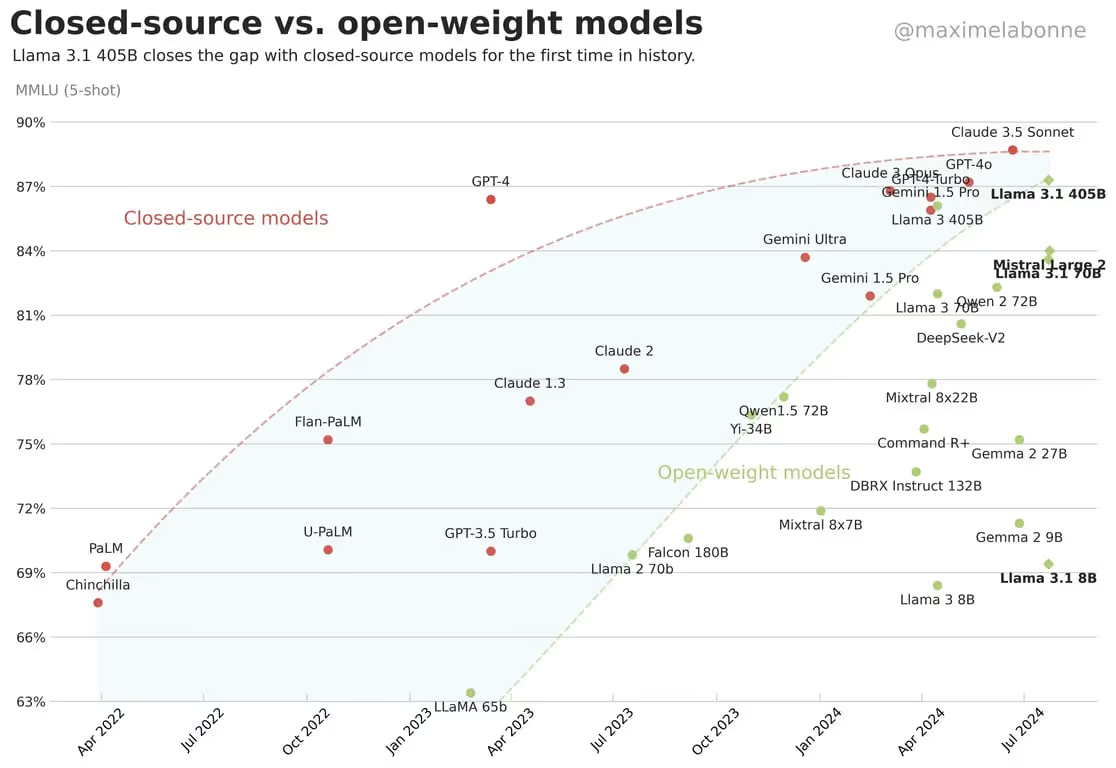

L’argument le plus évident qui justifie la montée en puissance des modèles Open-Weight est que l’écart de performance se réduit progressivement comparé aux modèles propriétaires.

C’est à partir de fin 2023 qu’on a pu constater que l’écart se réduisait. En effet, des chercheurs avaient publié une étude sur les modèles Open Weight à l’occasion du premier anniversaire de ChatGPT, et la conclusion principale de cette étude était que des LLM comme LLaMA 2 ou Falcon présentaient des performances comparables au modèle GPT-3.5 d’OpenAI.

Puis la tendance s’est confirmée en 2024 avec l’arrivée de modèles Open Weight sensiblement plus performants, comme on peut le voir sur le graphique de Maxime Labonne ci-dessous :

L’arrivée du modèle LLaMA 3.1 405B de Meta a fortement participé à réduire l’écart de performance, puisqu’il était capable de faire jeu égal avec des modèles propriétaires qui sont sortis la même année comme Claude 3 Opus, Gemini 1.5 Pro ou encore GPT-4o

D’une certaine façon, le succès de LLaMA 3.1 a bouleversé l’écosystème puisqu’il a provoqué le lancement d’une génération de modèles Open Weight qu’on ne peut pas voir sur ce graphique (puisqu’il remonte à juillet 2024), mais il est possible de faire une liste de ces modèles Open Weight qui ont émergé depuis, à commencer par les Large Language Models (LLM) :

- DeepSeek R1 a montré qu'il était possible d'atteindre des performances compétitives tout en réduisant considérablement les coûts d'entraînement par rapport à des géants comme OpenAI et Google

- DeepSeek R2 vise à rivaliser avec les modèles d'OpenAI sur les capacités de raisonnements.

- QWQ32B développé par Alibaba réussit à rivaliser avec des modèles ayant beaucoup plus de paramètres comme DeepSeek R1 (32 milliards de paramètres contre 67 milliards).

- Les modèles Qwen3 (Alibaba Cloud), même s’ils sont de taille inférieure, obtiennent des résultats compétitifs sur les benchmarks classiques comparés aux modèles de premier plan comme o1, Grok 1.5 ou Gemini 2.5 Pro.

- miniCPM-MoE 2.6 développé par OpenBMB présente des performances similaires à GPT-4o et Claude 3.5 Sonnet alors qu’il ne possède que 8 milliards de paramètres, permettant ainsi de faire tourner le modèle sur un PC.

- Mistrall Small 3.1 fait concurrence à GPT-4o mini

- La famille de modèles Exa One Deep créés par LG AI Research peuvent surpasser des modèles récents en mathématiques ou en codage. Par exemple, le modèle Exa One Deep 32B a atteint un score de 95,7 sur le benchmark Math500, surpassant le score de QWQ32B

Et encore, cette liste concerne uniquement les LLM. Il existe encore d’autres modèles Open Weight qui parviennent à s’illustrer dans des tâches spécifiques.

Dans la génération de vidéo, le modèle Wan 2.1 créé par Alibaba est le modèle Open-Weight ayant obtenu le meilleur score sur l’évaluation VBench et Step Video produit des vidéos plus cohérentes et stables que les modèles concurrents.

Pour ce qui est de la modélisation 3D, nous avons Hunyuan 3D développé par Tencent qui génère des objets 3D et le modèle STDG (Tencent/Ailab/Tsinghua) permet de générer des personnages 3D complets avec une personnalisation flexible.

L'accessibilité des modèles Open Weight

Les modèles d’IA à poids ouverts ne se contentent pas uniquement de concurrencer les modèles propriétaires sur la performance pure. Ils cherchent aussi à développer le modèle le plus efficient, c’est-à-dire la meilleure performance avec le moins de poids possible.

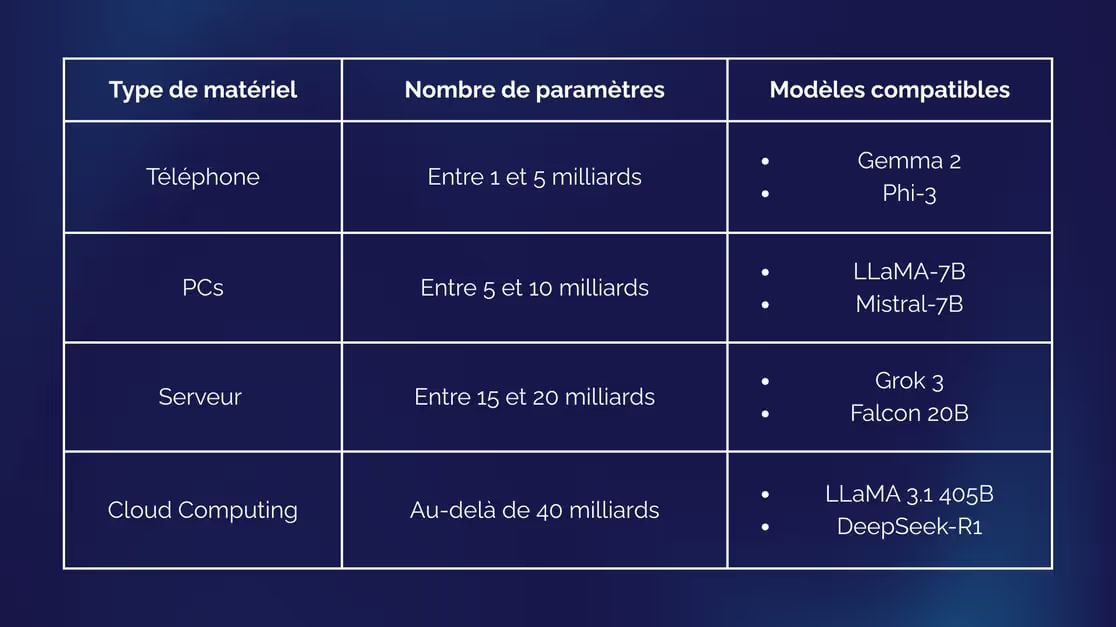

Voici un aperçu des machines nécessaires pour faire tourner un modèle en fonction de son nombre de paramètres :

Plus le nombre de paramètres est élevé, plus la machine doit être puissante pour faire tourner le modèle. A titre de comparaison, les modèles propriétaires comme GPT-4o d’OpenAI ou Claude 3.5 Sonnet ont respectivement 200 milliards et 175 milliards de paramètres, ce qui fait que leurs entreprises sont obligées de mettre au point leur propre infrastructure pour les faire tourner.

Pendant ce temps, les modèles à poids ouverts cherchent à créer les modèles d’IA les plus légers possibles, de façon à ce qu’ils puissent être déployés sur du matériel grand public et être utilisés en local.

Faire tourner un modèle d’IA localement sur du matériel grand public présente deux avantages comparé aux modèles propriétaires :

- La réduction des coûts. Là où les modèles propriétaires ont généralement recours à des datacenters, la plupart des modèles Open Weight proposent un modèle à faire tourner sur un PC ou un serveur de petite taille. De cette manière, on réduit à la fois les coûts liés au matériel et les coûts liés à l’énergie.

- La souveraineté des données. En local, on maîtrise l'ensemble de la chaîne de traitement des données. Cela permet d’être indépendant vis-à-vis des fournisseurs externes et de simplifier la conformité réglementaire sur le traitement et le stockage des données, surtout en Europe.

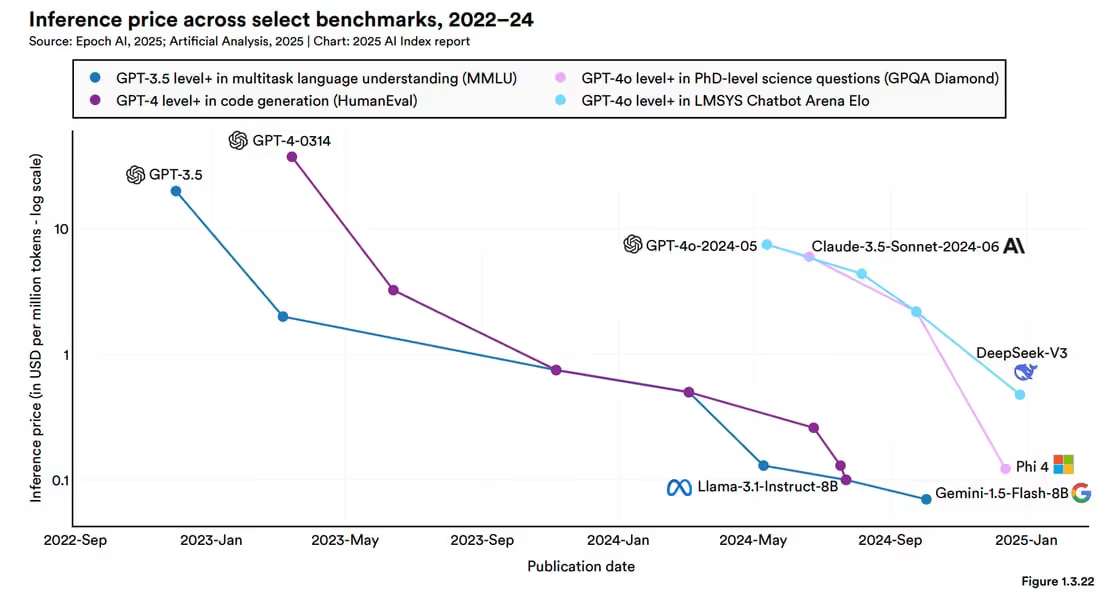

Globalement, le prix de l’inférence des modèles d'IA est en chute libre. Nous sommes passés de 20$/million de tokens en novembre 2022 à 0.07$/million de tokens en octobre 2024, soit une baisse de 99.7% du prix en seulement deux ans, et les IA Open Weight ont certainement eu une influence majeure sur cette baisse.

La transparence est une force

Les modèles Open Weight parviennent à réduire le gap de performance avec les modèles propriétaires, tout en cherchant à obtenir ces performances au moindre coût. Cela est possible car l’Open Weight utilise la transparence à son avantage.

Contrairement au modèles propriétaires qui se comportent comme des “boîtes noires”, les projets Open Weight offre un certain degré de transparence qui permet d'apprendre, de reproduire, d'adapter et de comprendre les outils

Il y a aussi plus de transparence sur la méthodologie, les données (lorsque celles-ci sont accessibles) et leurs résultats. C’est essentiel pour la crédibilité scientifique, et ça l’est tout autant pour l’évaluation des modèles.

A l’heure actuelle où la crédibilité des évaluations est de plus en plus contestée (notamment à cause du fait que les évolutions de modèles coûtent de plus en plus cher), la transparence permet des évaluations indépendantes et ainsi avoir un point de vue plus objectif sur la performance réelle d’un modèle.

Passer de Open Weight à Open Source

S’il y a des progrès concernant la transparence des modèles d’IA, nous ne pouvons pas encore les considérer comme étant Open Source.

Comme nous l’avons expliqué dans une précédente newsletter, rendre les poids accessibles ne représente qu’une partie du travail. Un modèle Open Source doit aussi rendre accessible son code source, ses données d’entraînement et avoir une licence de libre diffusion pour être considéré comme tel.

Beaucoup d'entreprises d'IA sont très réticentes à l'idée de rendre leurs données d'entraînement publiques. La justification la plus plausible a cette réticence est que leurs datasets contiennent du contenu protégé par les droits d'auteurs, ce qui aggraverait les poursuites en justice à leur encontre en ce moment-même.

Actuellement, très peu de modèles d’IA ont adopté cette démarche de créer des modèles pleinement Open Source, mais puisque le développement de l’IA est de plus en plus communautaire, on peut s’attendre à ce que la transparence gagne du terrain.

Les opportunités professionnelles

Les développeurs peuvent aussi tirer parti de cette transparence pour contribuer à cet écosystème. Montrer son travail est très pertinent pour gagner en visibilité, donc rejoindre une entreprise qui permet de montrer son travail ouvertement et publiquement est très précieux sur le long terme

Les contributions ouvertes que l'on crée sont vraiment importantes pour obtenir de bonnes positions tôt dans sa carrière, car même si on débute, il est recommandé en tant que professionnel de l’IA d'aller sur Hugging Face, d'essayer des choses, d'apprendre et de trouver des points à améliorer.

Par exemple, il n'y a pas beaucoup de datasets de préférence qui soient qualitatifs comparé aux datasets d'instruction. Créer un tel dataset serait une contribution très utile, et permettrait d’obtenir des opportunités plus importantes.

Webinar gratuit

Nos experts répondent à vos questions sur l'intelligence artificielle !

S'inscrire au Webinaire

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Finance Décentralisée

Accédez gratuitement à vos premières heures de formation Finance décentralisée

Accédez gratuitement à vos premières heures de formation Consulting Blockchain

Accédez gratuitement à vos premières heures de formation Consulting IA

Accédez gratuitement à vos premières heures de formation Développement Blockchain

Accédez gratuitement à vos premières heures de formation Développement IA

.avif)